C’è una scena del film di Kubrik “2001 Odissea nello Spazio”, in cui l’ultimo superstite a bordo della navicella spaziale comincia a estrarre a una a una le schede del computer Hal, scollegandone definitivamente il cervello pezzo dopo pezzo. È in quel frangente che Hal confessa di avere paura. Chissà se anche questa volta l’immaginazione umana arriverà a compimento. Non sarà facile, dovendo affrontare un tema ancora oscuro, che ha a che fare con quella “scatola nera” che ci rende noi stessi: il cervello.

Per prevedere il comportamento di una macchina complessa, è necessario poterne conoscere le caratteristiche strutturali e funzionali. L’approccio riduzionista, per cui l’analisi di un sistema complesso è ridotta a quella della somma delle sue componenti, ci fornisce una spiegazione che potremmo definire efficace nel caso di macchine relativamente semplici, ma diventa contraddittorio nel momento in cui abbiamo a che fare con macchine che contengono sofisticati programmi di controllo, come il caso dell’Intelligenza Artificiale (AI).

Ciò nonostante, da secoli l’uomo tende a confrontare se stesso con particolari categorie di macchine, che siano di natura meccanica, o chimica, fino a giungere al concetto di uomo come macchina informazionale. Secondo il matematico Marvin Minsky “Non vi è alcun motivo per credere che il cervello sia qualcosa di diverso da una macchina con un numero enorme di componenti che funzionano in perfetto accordo con le leggi della fisica”. Gli studi sull’AI ci hanno consentito di comprendere che l’informazione si stratifica su vari livelli, da quelli più bassi presenti nell’hardware a quelli più alti nel software, creando una sorta di gerarchia. L’intelligenza umana sarebbe quindi riducibile a un sistema costituito da una moltitudine di componenti elementari, dette “agenti della mente”.

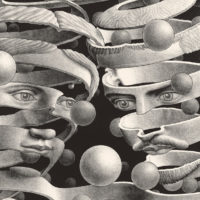

Se davvero la mente umana fosse riducibile a questo, potremmo controllarla e magari potenziarla. Ma siamo certi di conoscere a fondo noi stessi, al punto di riuscire a creare “menti artificiali” a nostra immagine e somiglianza?

Rifacendoci a un saggio intitolato “Il futuro che verrà”, supponiamo di avere a che fare con un computer che ha superato il test di Turing, per cui una persona che dialoga con una AI non deve essere in grado di capire se il suo interlocutore sia una macchina o un essere umano. Cosa dimostra il computer? Di avere una coscienza? E la coscienza è spiegabile, nella sua complessità?

Secondo il filosofo John Searle, coscienza e intenzionalità sono processi mentali che caratterizzano l’essere umano e ne contraddistinguono alcuni stati mentali, come le credenze, i desideri e le intenzioni, diretti verso oggetti e situazioni del mondo. Si tratta, cioè, di processi mentali che non possono essere ridotti ai processi computazionali di una macchina.

È indubbio che la coscienza intesa come ciò che interessa tutta una serie di dualità (veglia/sonno, attento/disattento, intenzionale/irriflessivo) sia già in parte esprimibile in termini di elaborazione informatica. Ma ciò che definiamo coscienza è qualcosa di più complesso, che non può prescindere dalle esperienze soggettive (come le sensazioni dovute a determinate circostanze).

Ancora oggi non siamo in grado di spiegare quali siano i meccanismi della nostra mente. Ragion per cui non possiamo neanche giudicare se in futuro un sistema AI potrà avere o meno una coscienza. Come declinò il filosofo Jerry Fodor “Nessuno ha la benché minima idea di come qualcosa di materiale possa essere cosciente. Nessuno sa nemmeno cosa voglia dire avere una minima idea di come qualcosa di materiale possa essere cosciente”.